Sur cette page

- Préface : Message de la chef

- Sommaire

- Introduction

- L’évolution du contexte

- Cadre de la stratégie en matière d’IA « 3+4+1 » du CST : Trois engagements

- Cadre de la stratégie en matière d’IA « 3+4+1 » du CST : Quatre fondements

- Cadre de la stratégie en matière d’IA « 3+4+1 » du CST : Un effort unifié en matière d’IA

- Prochaines étapes

- Annexe 1 : Principaux termes

Préface : Message de la chef

Vous savez toutes et tous que l’innovation, les données et la technologie font partie intégrante de qui nous sommes et de ce que nous faisons au Centre de la sécurité des télécommunications Canada. Lorsque je rencontre des personnes de notre organisme, que ce soit des cryptanalystes, des linguistes, des spécialistes en science des données ou des architectes de systèmes, je suis sans cesse impressionnée par leur engagement envers la mission et la créativité dont elles et ils font preuve pour résoudre certains des problèmes les plus complexes auxquels nous faisons face.

Les technologies émergentes et perturbatrices comme l’intelligence artificielle (IA) ne sont pas nouvelles pour nous. En fait, les outils et techniques de l’apprentissage automatique et de la science des données qui sont développés au CST contribuent depuis longtemps aux progrès réalisés en matière d’IA et d’apprentissage automatique au sein de la collectivité de la sécurité et du renseignement et de la société dans son ensemble. On ne saurait trop insister sur l’importance de tirer avantage de l’IA pour acquérir plus rapidement des connaissances pointues sur le contexte des menaces. En effet, nous ne pouvons nous permettre d’attendre et d’être relégués au second plan. L’IA ne changera pas notre façon de travailler, mais elle sera un outil vital parmi les nombreuses boîtes à outils que nous employons pour assurer la cybersécurité et collecter du renseignement électromagnétique étranger.

Bien entendu, comme c’est le cas avec la plupart des avancées technologiques, l’IA est une arme à double tranchant. Elle peut améliorer nos vies et le fera assurément. Cela dit, les auteures et auteurs de menace tireront également avantage de cette technologie à leurs propres fins, ce qui amplifiera l’incidence des menaces existantes sur la sécurité, comme c’est le cas pour les maliciels, les rançongiciels et le piratage psychologique.

Cette stratégie en matière d’IA permettra de s’assurer que nous sommes bien préparés à saisir toutes les nuances d’un contexte de menace en constante évolution et de plus en plus dominé par des auteures et auteurs de menace faisant appel à l’IA, et à nous y préparer. Au centre de cette stratégie en matière d’IA se trouve le même ingrédient secret qui fait du CST un organisme de sécurité et de renseignement de renommée mondiale : notre personnel extraordinaire, notre technologie de pointe et nos vastes partenariats.

Je mets au défi tout le personnel du CST à participer à cet effort et à parfaire ses connaissances en IA en participant activement aux débats et aux discussions et en tentant d’innover et d’expérimenter de façon sûre, sécurisée et responsable. Nous serons toujours judicieux et respectueux des règles dans notre adoption de l’IA, et la responsabilisation et la reddition de compte continueront de dicter la façon dont nous réaliserons nos objectifs. Sachant que ces technologies sont faillibles, nous procéderons à une expérimentation et à une mise en œuvre graduelles et concentrerons nos efforts sur une mise à l’essai et une évaluation rigoureuses, tout en veillant à solliciter l’intervention de nos spécialistes hautement qualifiées et qualifiés.

J’ai hâte de travailler avec vous toutes et tous pour appuyer cet effort unifié en matière d’IA et de tirer toutes ces leçons qui nous aideront à grandir en cours de route.

Votre chef,

Caroline Xavier (elle/la)

Sommaire

L’expertise du Centre de la sécurité des télécommunications Canada (CST) a évolué au fil des huit dernières décennies dans la foulée des avancées technologiques. Aujourd’hui, le CST est à l’avant-plan de la prochaine génération de technologies numériques et de communications, ce qui comprend l’utilisation de l’intelligence artificielle (IA) et de l’apprentissage automatique. L’organisme considère avec enthousiasme les nombreux bénéfices proposés par l’IA et tire profit de la technologie pour aider à protéger la sécurité nationale, la prospérité économique et les valeurs démocratiques du Canada, ainsi que la sécurité des Canadiennes et des Canadiens.

Le CST fait l’objet d’une période de croissance et de changement considérable alors que son environnement de menace évolue et que la demande pour ses produits et services augmente. Bien que l’organisme n’en soit pas à ses débuts en ce qui concerne l’IA et l’apprentissage automatique, le domaine de l’IA change rapidement et le CST doit s’y adapter. La Stratégie en matière d’IA du CST sera la première stratégie en son genre à mettre spécifiquement l’accent sur les technologies d’IA et d’apprentissage automatique, telles qu’elles s’appliquent à la mission de l’organisme. Il s’agit d’un document fondamental qui définit les principales orientations et les principaux objectifs d’un organisme qui a recours à l’IA à la suite de changements technologiques incroyablement rapides. La stratégie aidera à définir ses priorités, à orienter ses actions et à ancrer ses efforts pour peaufiner et adapter sa gouvernance, ses politiques et ses processus.

Alors qu’il mise sur un effort unifié en matière d’IA pour accroître son état de préparation, le CST s’engage à faire ce qui suit :

- développer de nouvelles capacités pour résoudre les problèmes critiques au moyen d’une utilisation novatrice des technologies d’IA et d’apprentissage automatique;

- promouvoir une IA responsable et sécurisée au cours d’une période d’innovation technologique rapide;

- contrer les menaces que les adversaires ayant recours à l’IA font peser sur le CST et la population canadienne.

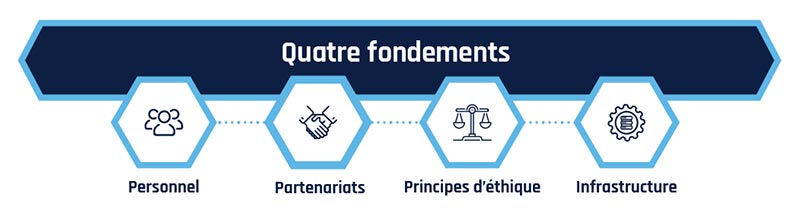

Les trois engagements décrits précédemment seront soutenus par les quatre fondements en IA de l’organisme :

- Personnel : habiliter les humains avec l’IA, et non les remplacer;

- Partenariats : établir des partenariats avec l’industrie, le milieu universitaire, la collectivité de la sécurité et du renseignement et le gouvernement du Canada dans son ensemble pour multiplier les capacités de l’organisme;

- Principes d’éthique : adopter des pratiques d’IA sûres, sécurisées, fiables et conformes à l’éthique;

- Infrastructure : mettre en place une infrastructure de gouvernance et de soutien de l’IA efficace, comme moderniser le calcul de haute performance et l’infrastructure de données de l’organisme.

Introduction

Le CST est l’organisme de cryptologie du Canada responsable du renseignement électromagnétique étranger, de la cybersécurité et des cyberopérations étrangères. Relevant du CST, le Centre canadien pour la cybersécurité (Centre pour la cybersécurité) est le responsable opérationnel et technique de la cybersécurité au gouvernement du Canada. Le Centre pour la cybersécurité représente une source unifiée d’avis, de conseils, de services et de soutien spécialisés en matière de cybersécurité pour le gouvernement, le secteur privé, la population canadienne ainsi que les propriétaires et les exploitants d’infrastructures essentielles.

Le mandat du CST est détaillé dans la Loi sur le Centre de la sécurité des télécommunications (Loi sur le CST) et comporte cinq volets :

- le renseignement étranger;

- la cybersécurité;

- les cyberopérations actives;

- les cyberopérations défensives;

- l’assistance technique et opérationnelle aux partenaires fédéraux.

En raison de son rôle au sein de la collectivité de la sécurité nationale du Canada, le CST fait de plus l’objet d’examens externes de la part de l’Office de surveillance des activités en matière de sécurité nationale et de renseignement et du Comité des parlementaires sur la sécurité nationale et le renseignement. Le commissaire au renseignement assume également une fonction de supervision indépendante quasi judiciaire pour ce qui est des activités liées au renseignement étranger et à la cybersécurité.

Le CST fait partie de la collectivité des cinq, l’alliance d’échange de renseignement la plus ancienne et la plus étroite du monde. La collectivité des cinq comprend les organismes de renseignement électromagnétique et de cybersécurité du Canada, de l’Australie, du Royaume-Uni, des États-Unis et de la Nouvelle-Zélande.

Le CST fait aussi partie d’un écosystème plus vaste qui regroupe la collectivité canadienne de la sécurité et du renseignement, le gouvernement du Canada, la collectivité de la défense, d’autres nations alliées, ainsi que des partenaires de l’industrie et du milieu universitaire. Si on regarde les principales priorités, comme la réalisation des engagements du gouvernement en matière de défense et la création prévue d’une capacité canadienne conjointe de cyberopérations, il sera de plus en plus crucial pour le CST de pouvoir compter sur ces partenariats pour assurer son succès. Les partenariats aideront également l’organisme à orienter les pratiques exemplaires de l’industrie, à tirer des avantages techniques et à intensifier la collaboration afin de résoudre les défis communs.

Objectif de la Stratégie en matière d’IA du CST

L’IA est une discipline étendue de l’informatique qui met l’accent sur des technologies qui démontrent des comportements généralement associés à l’intelligence humaine, comme l’apprentissage, le raisonnement et la résolution de problèmes. Bien que le CST n’en soit pas à ses débuts en ce qui concerne l’IA et l’apprentissage automatique, le domaine de l’IA change rapidement et l’organisme doit s’y adapter.

La Stratégie en matière d’IA du CST est un document fondamental qui définit les principales orientations et les principaux objectifs d’un organisme qui a recours à l’IA à la suite de changements technologiques incroyablement rapides. La stratégie définira les objectifs de l’organisme, guidera ses actions et ancrera les efforts qu’il déploie pour affiner et adapter sa gouvernance, ses politiques et ses processus à ce contexte de l’IA et des données qui ne cesse d’évoluer. Elle traitera de l’innovation et de l’intégration des capacités d’IA dans le cadre de son mandat, fera la promotion d’une IA responsable et sécurisée, et permettra de contrer la menace posée par une utilisation malveillante de telles technologies. La stratégie viendra s’ajouter aux politiques et aux directives du gouvernement fédéral en matière d’IA.

Cadre de la stratégie en matière d’IA « 3+4+1 » du CST : Trois engagements, quatre fondements, un effort unifié en matière d’IA

En tirant avantage de l’IA et de l’apprentissage automatique pour protéger la sécurité nationale du Canada, sa prospérité économique, ses valeurs démocratiques et la sécurité de sa population, le CST a pris trois engagements qui définissent sa mission, et a établi quatre fondements qui permettront de poser les bases nécessaires pour mener à bien ces efforts. Finalement, un effort unifié en matière d’IA guidera les actions du CST en ce qui concerne cette stratégie.

Il est capital pour la sécurité du Canada que le CST développe ses capacités d’IA et son expertise en adoptant une vision d’entreprise axée sur l’avenir et un objectif directeur voulant que les membres du personnel du CST soient en mesure d’utiliser l’IA et soient prêtes et prêts à le faire de façon responsable.

Description detaillée - Figure 1 : Cadre de la stratégie en matière d’IA « 3+4+1 » du CST : Trois engagements, quatre fondements, un effort unifié en matière d’IA

Cette image présente la vision stratégique qui repose sur l’adoption de la puissance de l’intelligence artificielle (IA), tout en veillant à une utilisation responsable.

Elle commence par trois engagements, qui font office de principes directeurs :

- Innover et intégrer l’IA pour assurer la sécurité nationale

- Promouvoir une IA responsable et sécurisée

- Comprendre et contrer la menace liée à l’utilisation malveillante de l’IA

Chaque élément de l’opération est représenté par une image dans un cercle. Chaque étape de l’opération est représentée par un chiffre en caractère gras, suivi d’une description de l’étape.

Les étapes de l’opération sont les suivantes :

- L’auteure ou auteur de cybermenace envoie un courriel contenant une image de suivi à la ou au destinataire

- La ou le destinataire ouvre le courriel et active l’image de suivi

- De l’information sur l’appareil et le réseau du destinataire, dont l’emplacement et l’adresse IP, est envoyée à un serveur contrôlé par l’auteure ou auteur de cybermenace

- L’auteure ou auteur de cybermenace utilise l’information pour mener des activités plus ciblées contre les routeurs domestiques et d’autres appareils du destinataire

L’évolution du contexte

Le CST honore une longue tradition et joue un rôle de chef de file dans le développement, l’adaptation et l’application de technologies de pointe pour mener à bien son mandat visant à assurer la sécurité du Canada. La science des données se trouve au cœur de la mission du CST. L’organisme y fait appel chaque jour pour convertir de grandes quantités de données en conseils exploitables basés sur du renseignement afin de veiller à ce que les dirigeantes et dirigeants du gouvernement du Canada puissent prendre des décisions stratégiques éclairées.

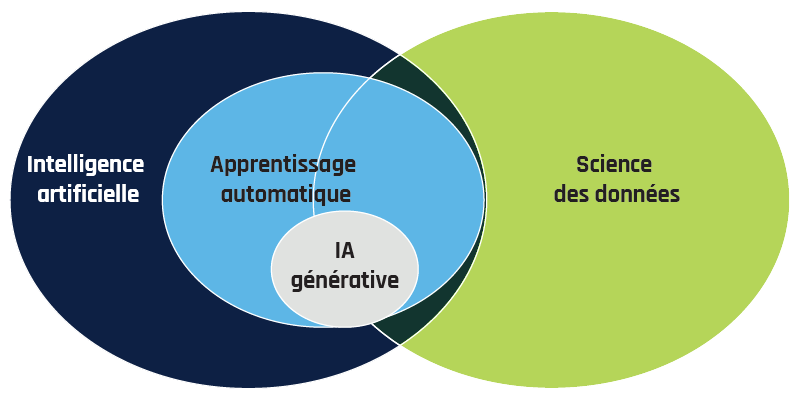

L’IA est un catalyseur clé de la science des données. Au cours des dernières années, un sous-domaine de l’IA appelé l’apprentissage automatique – où les algorithmes « apprennent des données » – est devenu un outil essentiel dans l’arsenal de la science des données. L’apprentissage automatique permet aux ordinateurs de résoudre des problèmes sans que l’utilisatrice ou utilisateur n’ait à programmer explicitement une solution étape par étape. Cet outil est essentiel lorsque les jeux de données analysés sont trop volumineux pour qu’une ou un programmeur puisse les consulter directement – un phénomène connu sous le nom de « mégadonnées ».

Récemment, un sous-domaine de l’apprentissage automatique appelé l’IA générative a pris le monde d’assaut (voir l’encadré « Modèles de langage de grande taille (LLM) »). Les algorithmes d’IA générative produisent du nouveau contenu (comme du texte, des images, des fichiers audio et vidéo ou du code de logiciel) qui ne pouvait traditionnellement qu’être produit par des humains. Les progrès réalisés dans l’IA générative ont mené aux nombreuses avancées récentes dans les techniques fondamentales de l’apprentissage automatique, offrant ainsi un grand avantage aux spécialistes en science des données, dont celles et ceux du CST. L’IA générative a progressé à une vitesse vertigineuse. Plusieurs personnes utilisent maintenant les termes « IA » et « IA générative » de manière interchangeable, bien que l’IA générative ne soit qu’un petit sous-ensemble des techniques de l’apprentissage automatique.

Description detaillée - Figure 2 : Rôle de l’IA dans l’écosystème de la science des données

Le diagramme de Venn illustre le chevauchement entre les domaines suivants :

- La science des données est représentée par un grand cercle orange. La science des données est un domaine de formation interdisciplinaire qui fait appel aux statistiques, au calcul scientifique et à la virtualisation pour extraire des connaissances tirées de jeux de données très volumineux. Elle se chevauche avec tous les autres domaines;

- L’intelligence artificielle (IA) est représentée par un grand cercle bleu foncé. L’IA est un élément clé de la science des données et elle implique le développement de programmes qui démontrent des comportements habituellement associés à l’intelligence humaine, comme dans l’apprentissage et la résolution de problème. Elle se chevauche avec la science des données, et elle englobe entièrement l’apprentissage automatique et l’IA générative;

- L’apprentissage automatique est représenté par un cercle moyen bleu pâle. L’apprentissage automatique est un sous-domaine de l’intelligence artificielle dans lequel des algorithmes apprennent comment effectuer une tâche à partir des données fournies sans qu’une utilisatrice ou un utilisateur ait à programmer explicitement une solution étape par étape. Il se situe entièrement à l’intérieur de l’IA, chevauche considérablement la science des données, et englobe entièrement l’IA générative;

- L’IA générative est représentée par le petit cercle vert. L’IA générative est un sous-domaine de l’apprentissage automatique et ses algorithmes produisent du nouveau contenu (comme du texte, des images, des fichiers audio et vidéo, ou du code de logiciel) qui ne pouvait traditionnellement qu’être produit par des humains. Elle se situe entièrement à l’intérieur de l’apprentissage automatique, et se chevauche avec la science des données.

En résumé, ce diagramme illustre les relations entre ces domaines, l’IA et la science des données chevauchant l’apprentissage automatique et l’IA générative comme forme spécialisée de l’apprentissage automatique.

Modèles de langage de grande taille (LLM)

LLMs Les modèles de langage de grande taille (LLM pour Large Language Model) sont un type d’IA générative qui produit du contenu sur la base d’informations saisies par l’utilisatrice ou utilisateur dans des invites. ChatGPT d’OpenAI et Gemini de Google sont des exemples bien connus de LLM. Les LLM d’usage général sont entraînés à partir de vastes collections de textes. Ce jeu de données pourrait inclure des copies entières d’Internet, pratiquement tous les livres écrits jusqu’à présent, tous les logiciels de source ouverte jamais créés et les transcriptions de toutes les vidéos en ligne.

Les LLM utilisent cet ensemble complet de matériel d’entraînement pour développer des modèles extrêmement sophistiqués de langage humain et ils peuvent produire du texte plausible pour presque toutes les requêtes. Malheureusement, les LLM ne sont pas infaillibles. Ils ne sont pas conçus pour raisonner, n’ont aucun concept de la numératie et ont tendance à fabuler. La mésinformation générée par des LLM est un problème suffisamment important pour que la collectivité de l’IA lui donne un nom : « hallucination ».

Comprendre la posture actuelle du CST à l’égard de l’IA

Le CST utilise l’IA pour renforcer la collecte et l’analyse de renseignement et protéger le Canada des cybermenaces. Par exemple, les technologies d’IA et d’apprentissage automatique :

- aident les linguistiques à traduire le renseignement étranger collecté dans des centaines de langues vers l’anglais et le français;

- renforcent la posture de cyberdéfense des réseaux canadiens essentiels;

- automatisent et exécutent des outils de détection des maliciels qui assurent une intervention rapide en cas de cybermenace (voir l’étude de cas « L’IA pour la cyberdéfense »).

Le CST est plus qu’un simple consommateur de technologies d’IA et d’apprentissage automatique, il est aussi un producteur. Tirant avantage de ses ressources uniques, dont ses superordinateurs et son expertise spécialisée, le CST contribue régulièrement à la collectivité élargie de l’IA, de l’apprentissage automatique et de la science des données (voir l’encadré « Exemple de réussite lié à la science des données – Uniform Manifold Approximation and Projection »). Le CST a recours à une recherche fondamentale pour résoudre les enjeux opérationnels et tisser des partenariats novateurs, comme les bourses remises aux collectivités de la recherche du CST et du Conseil de recherches en sciences naturelles et en génie du Canada, renforçant par la même occasion l’écosystème de recherche du Canada.Note de bas de page 1

Par le passé, le CST utilisait des techniques et des outils spéciaux – souvent conçus en interne – pour analyser ses jeux de données de plus en plus volumineux, mais les choses commencent à changer. Comme les problèmes liés aux mégadonnées sont de plus en plus courants, le CST peut avoir recours à des innovations commerciales et s’associer avec l’industrie et le milieu universitaire pour accroître sa capacité à mener à bien sa mission.

L’IA pour la cyberdéfense

Le CST utilise l’IA et l’apprentissage automatique pour soutenir ses efforts de cyberdéfense. Le Centre pour la cybersécurité s’efforce de protéger les systèmes fédéraux et ceux des infrastructures essentielles contre les cybermenaces. Ces efforts consistent notamment à détecter les schémas dans de vastes quantités de données. L’apprentissage automatique facilite la détection d’une gamme de menaces et permet d’assurer la sécurité de ces systèmes et de ces réseaux.

Classification des maliciels

La classification des maliciels est un autre exemple important de l’utilisation que fait le CST de l’IA. La classification des maliciels basée sur l’apprentissage automatique est capitale pour le CST, puisqu’elle facilite la détection et l’analyse des cybermenaces sophistiquées que les antivirus standard n’arrivent pas à détecter. Les réseaux du gouvernement du Canada sont souvent la cible d’attaques menées par des adversaires d’États-nations faisant appel à des maliciels sur mesure, ce qui exige des capacités de détection plus poussées que ce que peuvent offrir les logiciels antivirus commerciaux.

Les spécialistes en science des données du CST ont développé une nouvelle capacité de détection des maliciels qui arrive à détecter des maliciels qui passaient auparavant inaperçus sur les réseaux du gouvernement. Une fois que l’outil détecte de tels maliciels, il les met en quarantaine et les met de côté pour une analyse plus poussée. Comme il est peu pratique d’analyser manuellement chaque élément des maliciels présumés, le CST utilise également des outils antivirus commerciaux. S’il est déterminé que cet outil d’IA relève des maliciels avant les logiciels antivirus, il est possible de marquer ces exemples aux fins de réévaluation. Si le logiciel antivirus commence ultérieurement à catégoriser le fichier comme étant un maliciel, on sait que la prédiction était exacte et on peut ajuster le modèle en conséquence.

Exemple de réussite lié à la science des données – Uniform Manifold Approximation and Projection

L’Uniform Manifold Approximation and Projection (UMAP), qui se traduit par « approximation et projection uniformes de variétés », est un algorithme développé par le CST qui tire avantage des mathématiques avancées de manière à extraire efficacement les principales fonctions de données complexes. Cet algorithme peut être utilisé de maintes façons, notamment en visualisation, où le fait d’avoir une représentation visuelle des données complexes et volumineuses permet à l’humain de mieux comprendre les données en établissant des associations.

L’UMAP apprend d’abord la structure des données dans un espace de grande dimension, que l’on appelle la variété, puis trouve une représentation de dimension réduite de cette même variété afin de grouper les données qui coïncident avec l’intuition humaine. Les fondements mathématiques rigoureux permettent d’offrir un algorithme robuste et interprétable qui peut s’appliquer à une vaste gamme de problèmes liés à l’apprentissage non supervisé.

Le grand succès de l’UMAP repose sur la philosophie du CST qui consiste, dans la mesure du possible, à tenir compte des techniques fondamentales de la science des données plutôt que de s’attaquer à des problèmes en particulier. L’UMAP a d’abord été utilisé pour analyser des maliciels. Son utilisation s’est toutefois propagée au sein de la collectivité de la science des données en raison de sa vaste applicabilité à des jeux de données de types multiples et de sa disponibilité dans la collectivité des sources ouvertes. En 2020, par exemple, les épidémiologistes ont commencé à faire appel à l’UMAP pour analyser de vastes quantités de données complexes liées à la pandémie de la COVID-19. L’UMAP a même fait sa place au Museum of Modern Art (MoMA) de New York sous la forme d’une peinture sur l’IA mondiale intitulée Unsupervised – Data Universe – MoMA .

Depuis le lancement du code initial en 2018, l’UMAP a été téléchargé plus de 40 millions de fois et a été mentionné dans plus de 13 000 études abordant des sujets allant de l’apprentissage automatique à l’astrophysique. La réussite de l’UMAP démontre que le CST peut tirer avantage de son expertise unique en matière d’IA et d’apprentissage automatique pour contribuer à l’écosystème scientifique du Canada.

Vue d’ensemble des menaces liées à l’IA

L’IA offrira des avantages sur le plan de la cybersécurité, des affaires étrangères et de la défense. Dans les années à venir, le CST misera de plus en plus sur ses capacités d’IA et d’apprentissage automatique pour protéger le Canada et la population canadienne. Si elles sont déployées de façon sûre, sécurisée et efficace, ces capacités permettront au CST d’analyser des quantités plus grandes de données dans des délais plus rapides et avec une plus grande précision. Il sera ainsi possible d’accroître la qualité et la rapidité du processus de prise de décisions et des mesures d’intervention prises pour atténuer une multitude de menaces.

Ces outils puissants sont toutefois imparfaits. Ils posent des menaces pour les activités de collecte de renseignement et de cyberdéfense. L’IA fait également peser de nouveaux risques sur le Canada, sa population et ses institutions. Dans les mains d’adversaires, elle peut servir à automatiser et à amplifier les menaces existantes.

Certaines des plus grandes menaces anticipées par le CST découlent des dangers ou des répercussions négatives qui pourraient survenir advenant une mauvaise utilisation des capacités d’IA qui sont à la disposition des auteures et auteurs de menace étatiques et non étatiques.

Ces menaces comprennent notamment :

- des algorithmes capables de propager de la désinformation sophistiquée à grande échelle à une vitesse fulgurante, dont du faux contenu ou des « hypertrucages » qu’il pourrait être difficile de distinguer du contenu réel;

- la conduite à grande échelle d’activités d’hameçonnage automatisées, de fraudes et d’attaques par piratage psychologique;

- des systèmes de maliciels avancés et autonomes, particulièrement ceux ciblant les infrastructures essentielles;

- des systèmes améliorés de suivi cinétique et de ciblage des armes;

- des attaques basées sur les données, comme l’infiltration de requête, dans le cadre desquelles les comportements des modèles peuvent être partiellement contrôlés par les données en cours de traitement;

- des attaques par empoisonnement de modèles dans le cadre desquelles les modèles sont conditionnés à fournir des résultats erronés dans des circonstances particulières;

- l’érosion de la confidentialité et une plus grande difficulté à protéger les recherches de nature sensible et les données commerciales.

Les technologies d’IA n’ont pas à se trouver dans les mains d’adversaires pour poser des risques à la sécurité, à l’intégrité ou au bon fonctionnement des systèmes du CST, et ces risques peuvent prendre les formes suivantes :

- une erreur de l’utilisatrice ou utilisateur découlant d’un résultat inexact des modèles, d’un manque de formation ou d’un excès de confiance dans la technologie;

- de la mésinformation dans la mesure où les technologies de l’IA générative arrivent à produire du contenu qu’on peut difficilement distinguer de celui généré par l’humain;

- des défis pour ce qui est de faire en sorte que les résultats des modèles fournissent la transparence et l’explicabilité nécessaires;

- des attaques liées à la récupérabilité des données dans le cadre desquelles des données d’entraînement potentiellement sensibles peuvent être extraites ou déduites à partir des modèles.

Le CST est déterminé à utiliser l’IA et l’apprentissage automatique en gardant à l’esprit les facteurs liés à l’équité, à la transparence, à la responsabilisation et à l’autonomisation.

Sécurité pratique et informatique de l’IA

La sécurité informatique de l’IA traite des risques potentiels associés à des systèmes d’IA compromis. La sécurité pratique de l’IA, quant à elle, vise à s’assurer que les systèmes et les modèles d’IA fonctionnent de la manière prévue par leurs développeuses et développeurs sans donner lieu à des conséquences ou à des dommages imprévus. Dans le contexte du CST, il est essentiel de veiller à la sécurité pratique et informatique des systèmes d’IA pour réaliser la mission de l’organisme. Ces défis nécessitent une approche panorganisationnelle, ainsi qu’une collaboration avec les partenaires de la défense et du renseignement pour mieux comprendre la façon dont l’IA transforme les menaces qui pèsent sur la sécurité nationale et la cyberdéfense. Parallèlement, le CST doit envisager la sécurité pratique et informatique de l’IA à toutes les étapes de son cycle de vie, et ce, de la recherche à la production, afin d’anticiper et de gérer les risques de façon appropriée.

Futurs défis de l’IA

En plus des menaces que pose l’utilisation de l’IA, le CST anticipe que les nouvelles technologies d’IA et d’apprentissage automatique auront de grandes répercussions sur son contexte opérationnel, même s’il est difficile de prédire de façon précise quelles en seront l’ampleur et l’incidence. En voici des exemples :

- les fournisseurs intègrent l’IA à leurs produits, ce qui donne lieu à une utilisation non supervisée des technologies d’IA ou à une fuite involontaire de données à de tierces parties;

- un manque de transparence de l’industrie en ce qui concerne l’entraînement et le développement des modèles d’IA entrave la responsabilisation et porte atteinte à l’explicabilité pour les utilisatrices et utilisateurs;

- des problèmes de recrutement alors qu’augmente la demande pour des spécialisations en science de données font en sorte qu’il est difficile d’embaucher du personnel qualifié et de le maintenir en poste;

- l’accès à la puissance de traitement nécessaire pour exploiter les modèles d’IA modernes est de plus en plus problématique et il faut d’importantes ressources pour acheter, bâtir et maintenir de tels modèles, ce qui a des répercussions importantes sur l’environnement.

Le CST doit également tenir compte du fait qu’avec l’adoption grandissante des technologies d’IA par le gouvernement et l’industrie, il est de plus en plus essentiel de mettre en place des mesures de sécurité robustes en matière de cybersécurité. Il lui faut donc jouer un rôle prépondérant et veiller à rester à l’avant-plan des progrès techniques réalisés par l’IA. Il est notamment possible d’y arriver en améliorant l’exactitude et l’efficacité des outils de cybersécurité de l’organisme et en investissant dans sa capacité à prodiguer des conseils et des avis factuels fondés sur ses connaissances en matière d’IA.

Cadre de la stratégie en matière d’IA « 3+4+1 » du CST : Trois engagements

Pour tirer profit d’une technologie d’IA de pointe afin de mener à bien son mandat, le CST devra prendre les trois engagements clés suivants :

- Innover et intégrer l’IA pour assurer la sécurité nationale : Le CST utilisera l’IA pour fournir du renseignement fiable et une cybersécurité de pointe à ses partenaires fédéraux et provinciaux sur les enjeux touchant la sécurité nationale du Canada;

- Promouvoir une IA responsable et sécurisée : Le CST met à profit son expertise pour promouvoir le développement, le déploiement et l’utilisation d’une IA responsable et sécurisée dans l’ensemble du gouvernement du Canada;

- Comprendre et contrer la menace liée à l’utilisation malveillante de l’IA : L’organisme en apprendra plus sur la façon dont l’IA peut compromettre la sécurité du Canada et peaufinera son savoir-faire pour contrer les menaces que les adversaires utilisant l’IA font peser sur la population canadienne.

Innover et intégrer l’IA pour assurer la sécurité nationale

Il est primordial que le CST s’efforce d’obtenir un avantage technologique étant donné les progrès rapides réalisés par l’IA. Pour ce faire, l’organisme doit élaborer des approches novatrices à l’accès et améliorer ses méthodologies existantes afin de renforcer ses programmes de collecte, ainsi que ses fonctions de triage, de recherche et d’analyse des données.

Il doit également développer de nouvelles méthodes pour extraire de l’information de ces données plus rapidement et à plus grande échelle. Pour finir, l’organisme doit adapter graduellement son utilisation de l’IA en procédant à une expérimentation, à une mise à l’essai et à une évaluation sûres des modèles et de leurs applications, que ça soit en développant des outils internes ou en tissant des partenariats avec les spécialistes du gouvernement du Canada, le milieu universitaire et l’industrie.

Tandis qu’il continue d’intégrer l’IA dans l’organisme, le CST veillera à adapter constamment ses conseils, ses politiques et ses procédures de manière à respecter les normes les plus rigoureuses et à tenir compte des pratiques exemplaires émergentes. Il est impératif d’accorder la priorité à l’IA. Ne pas le faire retardera les priorités de la mission, nuira à l’analyse des données et permettra potentiellement aux adversaires de gagner du terrain.

Les principaux objectifs du CST pour accroître l’innovation et l’intégration de l’IA comprennent entre autres :

- développer des capacités multimissions pour accélérer le triage, la recherche et l’analyse du contenu;

- fournir de nouvelles informations et extraire les connaissances plus rapidement et à plus grande échelle, ce qui comprend les applications prometteuses de l’IA générative;

- explorer les façons de tirer avantage de l’IA pour soutenir les cyberopérations étrangères en étroite collaboration avec le ministère de la Défense nationale, Affaires mondiales Canada et les autres partenaires à qui l’organisme offre son assistance en vertu de la Loi sur le CST;

- déterminer en quoi l’IA peut améliorer la résilience aux cyberincidents et renforcer la cyberdéfense des systèmes importants pour le gouvernement du Canada, dont les infrastructures essentielles;

- tirer avantage de l’expertise fondamentale en matière de recherche de manière à ce que le CST demeure à l’avant-plan des nouvelles menaces et des nouvelles capacités;

- explorer les solutions d’IA commerciales, tout en continuant de concevoir des outils d’IA et d’apprentissage automatique sur mesure lorsque les options internes conviennent mieux à la tâche;

- déterminer les scénarios pour lesquels il est possible d’accélérer les procédures organisationnelles de routine au moyen de l’automatisation.

Promouvoir une IA responsable et sécurisée

Le CST mène ses activités en respectant des cadres juridiques et politiques rigoureux et il fait l’objet d’une supervision et d’examens externes. L’organisme est également tenu de mener ses activités conformément aux lois internationales et il est reconnu pour son respect de telles lois et des normes liées à la cybersécurité. Afin de se conformer à ces normes élevées en matière de loi et d’éthique, le CST s’efforce de développer et d’utiliser l’IA de manière responsable et conforme à l’éthique tout en protégeant le Canada des menaces à la sécurité faisant appel à cette technologie.

L’IA comporte des limites et des risques connus et inconnus. Pour régir et développer l’utilisation qu’il fait de ces outils puissants, le CST continuera de peaufiner ses pratiques pour permettre une utilisation responsable et sécurisée de l’IA. Dans le cadre de ce processus, l’organisme tirera avantage de ses perspectives diverses et de son expertise avec ses partenaires, le milieu universitaire et l’industrie. Il s’engagera à assurer une amélioration continue et à faire de la responsabilisation un principe directeur clé de son approche.

Dans sa nouvelle boîte à outils d’IA responsable, le CST renforcera ses approches en matière de gouvernance et de gestion des risques de manière à faire ce qui suit :

- tenir compte des considérations uniques à l’IA;

- promouvoir la responsabilisation;

- fournir aux utilisatrices, aux utilisateurs, aux décideuses et aux décideurs l’information dont ils ont besoin pour maximiser les avantages organisationnels tout en atténuant les risques.

L’IA responsable consiste également à développer et à utiliser l’IA en toute sécurité. En tant que conseiller de confiance et d’autorité technique pour la cybersécurité et l’assurance de l’information au sein du gouvernement du Canada, le CST joue un rôle clé dans la promotion du développement de systèmes d’IA sécurisés en ce qui a trait aux mesures de sécurité exhaustives en matière de cybersécurité, d’économie, de politique et de recherche.

Le CST tissera et maintiendra des partenariats avec les chefs de file des secteurs public et privé afin de renforcer la sécurité de leurs systèmes et de tirer des leçons de leur expertise dans ce domaine. Il doit également continuer de fournir des conseils et des avis pour soutenir ses partenaires et favoriser l’adoption de pratiques exemplaires dans les systèmes d’IA nationaux utilisés par la population canadienne, l’industrie, le gouvernement et le CST.

Les principaux objectifs du CST pour promouvoir une IA responsable et sécurisée comprennent notamment :

- le développement d’une boîte à outils d’IA responsable par le CST :

- la boîte à outils sera basée sur des pratiques de gestion des risques et une culture axée sur la conformité;

- elle favorisera l’équité, l’autonomisation, la responsabilisation et la transparence dans l’utilisation que l’organisme fait de l’IA;

- la mise en œuvre d’un processus de gestion des risques liés à l’IA :

- un nouveau cadre de gestion des risques appuiera le travail réalisé en ce sens;

- cette évaluation complète des techniques et des capacités d’IA permettra d’assurer une prise de décisions responsable;

- l’établissement de la réputation du CST comme centre d’expertise pour l’IA sécurisée au Canada :

- le CST positionnera la cybersécurité comme un aspect critique du développement sûr et sécurisé de l’IA;

- le Centre pour la cybersécurité proposera des conseils et des avis sur la cybersécurité optimisée par l’IA et tirera avantage de son réseau étendu de partenaires de confiance.

Comprendre et contrer la menace liée à l’utilisation malveillante de l’IA

L’IA est un multiplicateur de force; elle permettra d’accroître considérablement les capacités du CST, mais aussi celles de ses adversaires. La capacité du CST de soutenir les objectifs en matière de sécurité nationale et d’assurer la sécurité du Canada dépendra de son habileté à comprendre un contexte de cybermenace qui ne cesse d’évoluer.

Le CST est déterminé à poursuivre sa collaboration avec la collectivité de la défense, de la sécurité et du renseignement, et avec ses partenaires alliés pour offrir un avantage technologique dans la conduite de leurs missions malgré un environnement de menace qui change rapidement. Relever les défis liés à l’IA exigera des efforts soutenus de la part de tout l’appareil gouvernemental et de la société dans son ensemble.

Les principaux objectifs du CST pour contrer la menace posée par l’IA comprennent entre autres :

- proposer des produits, des services et des techniques qui permettent de sécuriser les systèmes d’IA et d’offrir une protection contre les menaces amplifiées par cette technologie;

- échanger du renseignement sur l’IA avec les partenaires pour acquérir une plus grande expertise de la façon dont elle accélère les menaces existantes (par exemple, la mésinformation) ou donne lieu à des risques émergents;

- mettre en place des capacités qui atténuent l’avantage que l’IA confère aux auteures et auteurs de menace lorsqu’un tel avantage nuit à la sécurité;

- continuer de mener des recherches fondamentales en IA et envisager d’étendre ces recherches pour obtenir un avantage scientifique sur les adversaires.

Cadre de la stratégie en matière d’IA « 3+4+1 » du CST : Quatre fondements

L’habilitation de l’IA qui appuie les trois engagements de l’organisme repose sur quatre fondements : le personnel, les partenariats, les principes d’éthique et l’infrastructure. Ces éléments fondamentaux soutiennent les efforts déployés sur le terrain pour mettre en œuvre les changements au sein du CST, en commençant par ceux à court terme et en vue de se préparer pour les développements à long terme.

Personnel

Il est capital de soutenir le personnel réputé du CST pour assurer la résilience de l’organisme dans la foulée de ces progrès technologiques. En permettant à un plus grand nombre d’employées et employés d’accéder aux capacités de l’IA, le CST vise à fournir à son personnel les outils nécessaires pour être plus efficace, en particulier en ce qui concerne ses fonctions en matière de renseignement électromagnétique, de cyberdéfense, d’habilitation et de recherche. Les employées et employés auront l’occasion d’acquérir des connaissances plus poussées de l’IA et d’appliquer ces technologies de façon responsable à mesure que l’IA s’intègre graduellement dans les activités quotidiennes de l’organisme.

Il est également essentiel que le personnel du CST assure la responsabilisation et la supervision de tous les aspects des activités de l’organisme. L’IA est un outil de soutien et les membres du personnel du CST doivent être en mesure d’expliquer et d’interpréter ses résultats. Peu importe les techniques et les capacités utilisées, il conviendra d’adopter un principe clé consistant à assurer une supervision humaine durant le processus de prise de décision – un principe caractérisé par « une intervention humaine » – et la principale responsabilité de l’organisme est d’orienter le développement et l’utilisation de l’IA.

Talent et formation

Le perfectionnement du personnel du CST se divise en deux volets : renforcer l’expertise technique de l’organisme en science des données, en IA et en apprentissage automatique, et créer des occasions panorganisationnelles de comprendre et d’employer la technologie que ces spécialistes aident à développer.

Les objectifs clés du CST mettront l’accent sur le talent et la formation, ainsi que sur l’élaboration de procédures opérationnelles claires qui soutiennent une utilisation responsable de l’IA. Ces objectifs comprennent entre autres :

- soutenir le développement continu des compétences du personnel en IA en misant sur la formation essentielle et le perfectionnement professionnel;

- développer une expertise pointue en IA en tissant une solide communauté en science des données au sein du CST, ce qui comprend attirer des personnes talentueuses qui ont de l’expérience avec les principes d’éthique de l’IA et en matière de gouvernance;

- recruter plus de personnes ayant des compétences stratégiques et sociotechniques pour soutenir l’intégration de l’IA dans l’ensemble du CST et du gouvernement du Canada;

- tirer avantage de l’expertise du CST en matière de science des données pour concevoir et développer des outils d’IA et d’apprentissage automatique sur mesure, et étendre la capacité de l’organisme en matière d’IA;

- rendre l’infrastructure technique, les données et les outils avancés plus accessibles aux personnes qui en ont besoin;

- tisser des partenariats de premier ordre avec les chercheuses et chercheurs de la collectivité des cinq, du milieu universitaire, des instituts de la sécurité de l’IA, des ministères gouvernementaux et des organismes de financement de la recherche;

- instaurer une culture organisationnelle de l’IA qui coïncide avec les principes d’inclusion, d’innovation et d’adaptabilité de l’initiative Un CST intégré.

Avec intervention humaine

L’utilisation que le CST fait de l’IA « enrichira le travail humain », permettant aux spécialistes en la matière d’effectuer leurs tâches de façon efficace et efficiente. Les efforts déployés auront pour but de découvrir et de mettre en évidence l’information pertinente pour la mission et le mandat de l’organisme, ainsi que l’utilisation de l’IA pour soutenir – et non remplacer – la prise de décisions humaine.

L’un des contrôles les plus efficaces du CST pour s’assurer que l’organisme mène ses activités en toute légalité et de manière responsable et conforme à l’éthique consiste à veiller à ce que l’humain intervienne dans le processus au moment de déployer l’IA. Des personnes humaines doivent être responsables des résultats des systèmes d’IA et en avoir le contrôle ultime. Pour soutenir cette responsabilisation, une intervention humaine par une ou un spécialiste en la matière est nécessaire pour assumer la responsabilité des résultats générés par IA qui servent à orienter la prise de décisions.

Étude de cas – L’IA pour l’enrichissement des données

L’enrichissement des données est un processus qui consiste à améliorer les jeux de données existants en y insérant de l’information additionnelle ou des caractéristiques utiles. Il est ainsi possible d’accroître les performances des modèles en améliorant la qualité (ou la quantité) des données. L’enrichissement peut également rendre les données plus accessibles pour les analystes humaines et humains ou les autres outils d’IA ou d’apprentissage automatique.

La traduction automatique pour l’analyse du renseignement

La traduction automatique est un exemple de la façon dont le CST utilise l’enrichissement des données optimisé par l’apprentissage automatique. Grâce à cette capacité, le texte en langue étrangère peut être traduit automatiquement dans la langue maternelle d’une ou un analyste, ce qui permet d’effectuer une analyse rapide et précise de données auxquelles il aurait été impossible d’accéder aux fins de consultation ou d’interrogation. Le CST a développé des modèles de traduction automatique dans plusieurs langues qui sont hautement concurrentiels et, dans plusieurs cas, supérieurs aux modèles similaires des plus grands laboratoires de recherche internationaux en IA.

Il est important de souligner que la traduction automatique sert à des fins de triage au CST en vue d’améliorer la découvrabilité et l’accessibilité des données aux fins d’analyse avec interprétation humaine. Comme importante mesure de sécurité – et conformément au principe exigeant une intervention humaine –, ces traductions sont d’abord validées par les linguistes du CST avant d’être utilisées dans le cadre d’un processus de prise de décision ou de production de rapports. Il est ainsi possible d’assurer le niveau le plus élevé de précision et de fiabilité dans des situations critiques.

Partenariats

Les relations du CST avec la collectivité des cinq demeurent essentielles et pour rester à l’affût des développements technologiques, l’organisme doit établir des partenariats de confiance avec l’industrie et le milieu universitaire. Maintenant que la science des données, la gestion de l’information et l’apprentissage automatique deviennent de plus en plus essentiels pour assurer l’efficacité des activités, le CST doit reconnaître que les entreprises technologiques et les chercheuses et chercheurs du milieu universitaire ont certains avantages qu’il pourrait être impossible d’égaler sans aide extérieure.

Le CST tentera de renforcer ses partenariats avec les organisations dont les domaines d’expertise sont différents des siens. Il pourra ainsi tirer le maximum de ses avantages, comme son environnement classifié et son personnel hautement qualifié, pour permettre des échanges précieux avec des partenaires qui se trouvent à l’avant-plan du développement technologique.

L’organisme s’efforcera de faire ce qui suit :

- tirer avantage des partenariats avec l’industrie, le milieu universitaire et la collectivité de la sécurité et du renseignement pour obtenir de nouvelles connaissances technologiques;

- définir et mener à bien les priorités conjointes de la collectivité des cinq, en particulier dans les secteurs où le CST peut faire des contributions importantes;

- renforcer les relations existantes avec les chefs de file de l’IA du secteur privé canadien;

- tenir des portes ouvertes pour renforcer l’engagement entre le CST, les partenaires de l’industrie et les instituts de recherche axés sur l’IA, comme le Conseil national de recherches Canada, l’Institut canadien de la sécurité de l’IA et les autres organismes qui développent une capacité de tests et évaluent la sécurité des modèles d’IA;

- nouer des partenariats avec les organisations qui orientent le développement de la technologie d’IA dans le secteur privé et au sein de la collectivité de la sécurité et du renseignement.

Principes d’éthique

La boîte à outils d’IA responsable du CST est au cœur des efforts déployés par l’organisme pour mettre en œuvre l’IA de façon conforme à l’éthique. Ces outils permettront aux employées et employés de reconnaître, de comprendre et d’atténuer les risques liés à l’utilisation de l’IA. Le processus de gestion des risques liés à l’IA facilitera l’évaluation des risques opérationnels et techniques, ainsi que ceux liés à la réputation, aux autorisations et au bien-être, qui sont associés avec les nouveaux cas d’utilisation de l’IA au CST.

Les principaux objectifs pour assurer une mise en œuvre de l’IA conforme à l’éthique comprennent la mise en place de procédures visant à assurer une utilisation uniforme et légale de l’IA, de même que la publication et la communication d’initiatives permettant de garantir que les processus internes de l’organisme reflètent les normes et la réputation du CST. Conformément à la Loi sur le CST et à l’esprit des directives et lignes directrices du gouvernement du Canada, l’organisme s’efforcera de déployer l’IA de manière à faire preuve d’équité, à respecter la vie privée de la population canadienne et à atténuer les biais.

Le développement et le déploiement de l’IA aux fins de la sécurité nationale présentent certains défis uniques sur le plan de l’éthique. L’organisme devra compter sur l’expertise de ses spécialistes et des processus spécialisés pour minimiser les biais et la discrimination, et déployer l’IA en appliquant des mesures de protection claires. Initialement, cela exigerait l’amélioration des approches adoptées par le CST en matière de gestion des risques et le développement d’un programme d’apprentissage et de perfectionnement pour communiquer des lignes directrices et des mesures de protection claires aux développeuses, aux développeurs, aux utilisatrices et aux utilisateurs. Pour se guider, l’organisme misera également sur des principes d’éthique liés à l’IA qui s’inscrivent dans ceux mis en place par le gouvernement du Canada et des alliés internationaux aux vues similaires.

Approches du CST concernant les principes d’éthiques liés à l’IA

Axés sur l’humain : Un équilibre entre l’orientation technologique et l’application du jugement humain sera établi et on s’assurera que le personnel peut s’adapter à mesure que la technologie évolue.

Équitables : Les biais indésirables seront identifiés et atténués au cours de la conception technique et dans les données utilisées pour éviter toute discrimination.

Responsables : Des personnes humaines seront responsables des résultats des systèmes d’IA et en auront par conséquent le contrôle ultime. Pour soutenir cette responsabilisation, une intervention humaine par une ou un spécialiste en la matière permettra de valider les résultats générés par IA qui orientent la prise de décisions.

Efficaces : On fera appel à l’IA pour améliorer les résultats de la mission tout en reconnaissant ses limitations et ses répercussions sur l’environnement.

Conformes à la loi : On utilisera l’IA d’une manière qui respecte la dignité humaine et les valeurs démocratiques. L’utilisation de l’IA sera pleinement compatible avec les autorisations légales, les politiques et les procédures applicables, ainsi qu’avec les normes d’éthique du CST.

Sécurisés : On développera et emploiera des pratiques exemplaires pour maximiser la fiabilité, la sécurité et l’exactitude de la conception, du développement et de l’utilisation de l’IA. On mettra en place des pratiques exemplaires en matière de sécurité pour renforcer la résilience, assurer la sécurité des utilisatrices, des utilisateurs et des bénéficiaires, et minimiser les risques d’influence par des adversaires.

Le CST mettra en œuvre l’IA de manière éthique en prenant les mesures suivantes :

- concevoir une boîte à outils d’IA responsable pour promouvoir une IA responsable et sécurisée, en se basant sur des pratiques de gestion des risques et une culture axée sur la conformité;

- accroître la sensibilisation organisationnelle de l’IA et favoriser un dialogue constructif concernant l’utilisation éthique de l’IA à tous les niveaux de l’organisation;

- développer et mettre en œuvre des efforts organisationnels pour gérer les risques lors du développement, de la mise à l’essai et de l’utilisation de l’IA;

- analyser les cadres juridiques qui régissent le développement et l’utilisation de l’IA afin de contrer, entre autres, les menaces antagonistes;

- promouvoir une IA responsable en publiant une stratégie non classifiée en matière d’IA qui démontre la transparence et renforce la confiance du public;

- développer des capacités de gouvernance et d’assurance de la qualité pour déployer des modèles d’IA et des systèmes de soutien conçus par la collectivité des cinq et d’autres partenaires clés;

- codifier la sensibilisation aux principes d’éthique, aux risques, aux répercussions et aux stratégies d’atténuation en matière d’IA dans les pratiques de l’organisme sous forme de stratégies de communication internes, comme une campagne de formation et de perfectionnement.

Infrastructure

Lorsque de nouvelles technologies d’IA émergent, leur incidence varie selon l’efficacité avec laquelle les organisations établissent les conditions appropriées pour leur acquisition, leur innovation et leur déploiement. Bien que le CST utilise l’IA et l’apprentissage automatique depuis longtemps pour mener à bien sa mission, la récente évolution rapide des technologies d’IA exige que l’on réexamine l’infrastructure nécessaire pour tirer avantage de ces progrès. Cela comprend, entre autres, l’infrastructure de soutien, comme le calcul de haute performance (CHP), l’infrastructure de données et la gouvernance.

Calcul de haute performance (CHP)

L’IA transforme la définition du CHP. Le CST a toujours maintenu sa propre infrastructure de CHP, ce qui lui a permis de réaliser sa mission de la manière la plus sécurisée possible. Cela dit, alors que l’IA devient de plus en plus populaire au sein de la population, l’industrie et les gouvernements se tournent de plus en plus vers l’informatique en nuage afin de limiter le recours aux superordinateurs sur site pour traiter les charges de travail associées à l’IA. Le CST doit établir un équilibre judicieux entre ses besoins spécialisés et les avantages offerts par les technologies infonuagiques sécurisées, tandis qu’il s’efforce de moderniser son infrastructure informatique pour gérer les charges de travail modernes de l’IA.

L’objectif du CST est de développer une infrastructure technique sécurisée, puissante, adaptable et prête pour l’IA à mesure qu’évoluent les technologies et les politiques.

Pour ce faire, le CST doit :

- déterminer la puissance de traitement et l’infrastructure technique nécessaires pour utiliser et déployer les systèmes d’IA dans l’avenir;

- intégrer une stratégie de données qui soutient la capacité du CST à mener des recherches fondamentales et appliquées sur les vulnérabilités et l’exploitation des systèmes d’IA;

- respecter les engagements du Canada en ce qui a trait aux objectifs de développement durable;

- considérer les coûts énergétiques et les possibles répercussions environnementales de plusieurs systèmes d’IA générative au moment de prendre des décisions opérationnelles.

Infrastructure et gouvernance des données

Afin d’utiliser efficacement l’IA et l’apprentissage automatique pour réaliser sa mission, le CST doit continuer d’être un intendant de données de calibre mondial et rendre les données accessibles dans tout l’organisme pour faciliter le traitement au moyen des technologies d’IA et d’apprentissage automatique, tout en protégeant la source et l’intégrité de ces données. À ce titre, il lui incombe de protéger la vie privée des Canadiennes et des Canadiens conformément à ce qui est énoncé dans la Loi sur le CST. L’organisme devra explorer une vaste gamme d’options pour le stockage et la gestion des données relevant de ses cadres juridiques qui visent à protéger les données sensibles.

Il devra pour ce faire mettre en place une infrastructure de stockage des données extensible et hautement performante, mettre à jour ses pratiques strictes en matière de gouvernance et de conformité des données et sécuriser l’accès aux données sources qui sont importantes pour sa mission.

La qualité des données est un autre aspect important dont il faut tenir compte. Le CST ne peut pas simplement acquérir des données depuis une source et s’attendre à ce que tout soit parfait. Examiner les sources de données fournira des indications sur leur fiabilité, mais l’organisme doit vérifier la qualité des données par lui-même. Pour atteindre ces objectifs, le CST doit mettre en place la gouvernance, les processus et les outils nécessaires pour s’assurer que l’utilisation qu’il fait des données est légale et conforme à l’éthique, et que les sources de données et les fonctions de conformité sont disponibles tout au long de la chaîne de traitement des données. Les analystes doivent toujours savoir si les données qu’elles ou ils examinent ont été générées par un algorithme et être en mesure de faire le suivi des augmentations de données jusqu’à leur source.

La gouvernance des données a également évolué de façon importante dans l’ère de l’IA moderne. Elle doit maintenant tenir compte de la polyvalence, de l’extensibilité et de l’automatisation, tout en assurant la conformité, la qualité des données et la sécurité. Les politiques des données doivent aborder non seulement le respect de la vie privée et le contrôle de l’accès, mais aussi une utilisation conforme à l’éthique de l’IA, la provenance des données et l’atténuation des biais dans les modèles d’apprentissage automatique. La gouvernance des données devrait fournir un équilibre entre les contrôles nécessaires et le besoin de faire appel à l’innovation, afin d’assurer une utilisation sécurisée des données et une souplesse dans la prise de décisions axées sur les données.

Cadre de la stratégie en matière d’IA « 3+4+1 » du CST : Un effort unifié en matière d’IA

Les technologies d’IA redéfiniront le contexte opérationnel du CST. Alors qu’il explore ces nouvelles capacités, l’organisme devra être en mesure d’adopter une approche panorganisationnelle pour assurer sa réussite. L’IA améliorera l’efficience et l’efficacité du CST à tous les niveaux de l’organisme. Pour adapter ces capacités, l’organisme devra déployer des efforts continus et consacrer des ressources. Il doit intégrer les technologies d’IA tout en préparant son personnel dans le cadre d’initiatives de formation et de perfectionnement.

Les objectifs clés du CST en ce qui a trait à l’initiative Un effort unifié en matière d’IA comprennent notamment :

- remanier les politiques et procédures en matière d’IA pour refléter le nouvel environnement basé sur l’humain et la machine;

- remanier les structures de gouvernance du CST, ce qui comprend explorer la possibilité de créer un organe central qui pourrait coordonner la mise en œuvre de la stratégie;

- créer des guides opérationnels, des programmes de formation et d’autres outils qui guideront les employées et employés dans l’adoption des technologies d’IA.

Prochaines étapes

Pour assurer une mise en œuvre réussie de cette stratégie, tout l’organisme devra déployer des efforts pour développer des technologies d’IA et les appliquer de façon responsable. Comme l’IA continue d’évoluer rapidement, l’approche adoptée par le CST en ce qui a trait à sa gouvernance restera dynamique et souple.

La mise en œuvre de la stratégie exigera les efforts concertés et soutenus de tous les secteurs du CST. Le CST continuera de s’assurer que ces puissantes technologies respectent des normes rigoureuses sur le plan juridique et de l’éthique, et que l’organisme gère ces risques de manière à en maximiser les avantages. Il continuera également de contribuer activement aux principaux partenariats et lors des forums auxquels participent la collectivité des cinq et le gouvernement du Canada afin de trouver des solutions aux enjeux communs.

Le CST réévaluera régulièrement la stratégie en matière d’IA et la passera en revue pour s’assurer qu’elle s’adapte aux plus récents progrès réalisés en IA et aux plus récentes pratiques exemplaires en la matière, tout en veillant à respecter son mandat.

Annexe 1 : Principaux termes

- Agent conversationnel :

- Interface utilisateur qui simule une conversation interactive avec une participante ou un participant intelligent. Les agents conversationnels peuvent être utilisés pour la recherche documentaire, les requêtes interactives ou en tant qu’interface pour d’autres capacités.

- Apprentissage automatique :

- Sous-domaine de l’intelligence artificielle dans lequel des algorithmes apprennent comment effectuer une tâche à partir des données fournies sans qu’une utilisatrice ou un utilisateur ait à programmer explicitement une solution étape par étape. Les modèles de l’apprentissage automatique peuvent offrir des performances similaires ou supérieures à celles de l’humain pour ce qui est d’exécuter certaines tâches, comme relever les schémas dans les données.

- Attaques par empoisonnement de modèles :

- Attaques qui surviennent lorsqu’une ou un adversaire manipule intentionnellement les paramètres d’un modèle d’IA ou d’apprentissage automatique de manière à ce qu’il se comporte de façon indésirable.

- Avec intervention humaine :

- Système d’IA qui exige une intervention humaine avant d’avoir une incidence sur le résultat. Elle reflète la nécessité de fournir une supervision humaine des décisions ayant une incidence plus grande.

- Enrichissement des données :

- Processus visant à enrichir les jeux de données existants avec de l’information ou des caractéristiques additionnelles afin d’améliorer les performances du modèle ou la qualité des données, ou de faire en sorte qu’il soit plus facile d’associer les processus à la chaîne de traitement d’apprentissage automatique (par exemple, générer des étiquettes, extraire des caractéristiques, saisir des valeurs manquantes).

- Exploration et triage des données :

- Acte qui consiste à rendre de grandes quantités de données compréhensibles pour une ou un analyste humain. Le triage de données comprend l’analyse et la synthèse de grands jeux de données pour réduire les volumes de données et relever les schémas, les anomalies et les domaines d’intérêt. Ces processus font appel à des techniques comme la réduction de dimension, le groupage, la détection des anomalies et la virtualisation. Ils aident les humains à comprendre les données, à prendre des décisions et à prioriser une analyse plus poussée.

- Extraction et représentation de connaissances :

- Processus qui consistent à convertir les résultats dans des formats accessibles en lecture par l’humain et la machine. L’extraction signifie généralement le fait de rendre quelque chose lisible par un humain, tandis que la représentation consiste à la rendre lisible par une machine. Une caractéristique clé de ces outils est de préserver la vérité des données sous-jacentes.

- Génération de code :

- Processus visant à générer des extraits de code source à utiliser dans le cadre du développement d’un logiciel, qui repose sur une description en langage naturel de la fonctionnalité ou des suggestions découlant d’un code incomplet (« remplissage automatique »). La génération de code permet d’automatiser de petites tâches pour tester rapidement des fonctionnalités.

- Génération de médias :

- Processus similaire à la génération de texte, mais pour les données de fichiers audio, de vidéos ou d’images. Les médias générés sont décrits au moyen d’un langage naturel. Il s’agit, par exemple, de la génération de texte en image, de la génération de vidéos et du clonage de la voix ou d’images. La génération de médias peut comprendre la capacité de varier le style des médias générés.

- Génération de texte :

- Processus qui consiste à utiliser une petite quantité de texte pour générer de plus grands volumes de texte. Il peut comprendre la capacité de varier le style des médias générés.

- Hameçonnage :

- Procédé par lequel une tierce partie tente de solliciter de l’information confidentielle appartenant à une personne, à un groupe ou à une organisation en usurpant ou en imitant une certaine marque généralement bien connue dans le but d’obtenir habituellement des gains financiers. Les hameçonneuses et hameçonneurs incitent les utilisatrices et utilisateurs à fournir leurs renseignements personnels (numéros de carte de crédit, données bancaires en ligne ou autres renseignements sensibles) afin de s’en servir pour commettre des actes frauduleux.

- IA générative :

- Sous-domaine de l’apprentissage automatique qui génère du nouveau contenu en se basant sur les jeux de données de grande taille qui alimentent le modèle. L’IA générative peut créer du contenu dans divers formats, comme du texte, des images, des fichiers audio ou vidéo et du code de logiciel.

- Infiltration de requête :

- Type de cyberattaque ciblant les LLM. Les attaquantes et attaquants camouflent les résultats malveillants sous forme d'invites légitimes et manipulent les systèmes d’IA générative de manière à ce que ces derniers accomplissent sans le vouloir les buts qu’ils se sont fixés.

- Intelligence artificielle (IA) :

- Sous-domaine de l’informatique qui développe des programmes informatiques intelligents capables d’adopter des comportements généralement associés à l’intelligence humaine (par exemple, résoudre des problèmes, tirer des leçons, comprendre une langue, interpréter des scènes visuelles).

- Modèles de langage de grande taille (LLM) :

- Type d’IA générative entraînée au moyen de jeux de données linguistiques de grande taille qui permettent de créer un langage semblable à l’humain capable d’échanger sur un sujet donné à partir des invites soumises par les utilisatrices et utilisateurs. ChatGPT d’OpenAI et Gemini de Google sont des exemples bien connus de LLM.

- Piratage psychologique :

- Pratique qui consiste à obtenir des renseignements confidentiels en manipulant des utilisatrices et utilisateurs légitimes. Une ou un pirate psychologique utilisera généralement le téléphone ou Internet pour tromper les gens et les inciter à révéler de l’information sensible. Par exemple, l’hameçonnage est un type de piratage psychologique.

- Résumé de texte :

- Processus qui consiste à condenser de grandes quantités de textes en de brefs résumés tout en conservant la principale signification du texte d’origine. Il peut comprendre des liens explicites vers le matériel source ou encore un extrait ou une paraphrase de la signification voulue.

- Science des données :

- Domaine de formation interdisciplinaire qui fait appel aux statistiques, au calcul scientifique, aux méthodes scientifiques, au traitement, à la visualisation, aux algorithmes et aux systèmes scientifiques pour extraire ou extrapoler des connaissances tirées d’ensembles de données structurées ou non structurées. La science des données fait largement appel à l’apprentissage automatique pour atteindre ces objectifs.

- Sécurité informatique de l’IA :

- Protection des systèmes d’IA pour assurer la confidentialité, l’intégrité et la disponibilité du système et de ses données et défendre ces systèmes contre les attaques d’une ou un adversaire.

- Sécurité pratique de l’IA :

- Domaine interdisciplinaire axé sur la prévention des accidents, l’utilisation abusive ou d’autres conséquences néfastes associées aux systèmes d’IA.